生成式人工智能领域已经出现了 CLIP、DALL-E、FLORENCE、Turing Bletchley、ALIGN 和 BASIC 等强大的语言视觉模型。

这些生成式人工智能大模型可以在没有特定标签的情况下适应新的数据集,但目前面临的挑战是大规模图像-文本对训练数据集的稀缺。

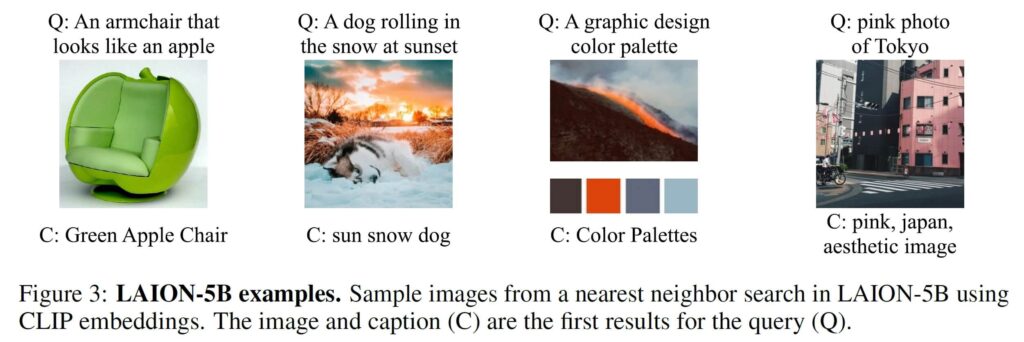

LAION-5B – 开放式大规模图像文本对数据集

LAION 5B 是一个包含 58.5 亿高质量图像-文本对的开源数据集,其中包含探索和训练工具,可为 DALL-E 架构提供支持,并为广大社区推进多模态语言-视觉模型研究。

LAION-5B 的三个子集包括:

- 23.2 亿个英文图像-文本对。如果语言从上下文语境中可以看出,该子集被称为 LAION-2B-en 或 LAION-2B。

- 来自 100 多种其他语言的 22.6 亿个图像-文本对。在多语言子集中,使用频率最高的前五种语言分别是俄语(10.6%)、法语(7.4%)、德语(6.6%)、西班牙语(6.6%)和汉语(6.3%)。

- 12.7 亿个无法检测语言的样本,通常显示产品或地点。检查发现,标题语言有意义,但可能掺杂了搜索引擎优化关键词或产品标签。

LAION-5B 所包含数据的多样性和复杂性,如数据重叠、图像噪声和不恰当图像的筛选等,使我们能够更深入地研究低资源语言和自然语言在多模态应用中的作用,同时也揭示了潜在的模型偏差。它支持:

- 多模态预训练和图像匹配:改进 CLIP 等图像嵌入模型,以改进图像检索和zero-shot分类。

- 图像生成: 使用稳定扩散和 Imagen 等模型的LAION-5B子集,促进高分辨率和基于文本的图像生成,从而实现高质量和创造性的输出。

- 文本生成: 支持图像生成文本,视觉问题解答(VQA)和视觉关联任务,以提高语言模型在 VQA 中的性能。

- 分类和识别任务: 在开发识别和分类模型时,可用于zero-shot学习或微调。

不过,在使用 LAION-5B 解决工业问题时要谨慎,因为带有水印或不恰当内容的未筛选图像可能会影响模型训练。

互联网公开数据集的三大挑战

首先,LAION-5B上的数据凸显了互联网数据质量低下这一日益严重的问题。

原因在于,互联网数据种类繁多、质量参差不齐,这给大语言模型(LLM)、多模态大模型(MLLM), 以及生成式预训练Transformer(GPT)等技术的训练和应用带来挑战,因为低质量数据可能导致结果偏差或误导,影响模型的性能和可靠性。

其次,互联网数据的版权问题令人担忧。未经授权的使用可能会导致法律纠纷,这对依赖数据的大模型来说是个严峻的问题。

最后,由于 LLM,MLLM,GPT 等先进模型的需求不断增长,互联网数据消耗量也在不断上升,导致数据使用量超过数据创建速度,造成数据短缺。

马达智数推出面向多模态大模型的图像-文本对商用数据集

马达智数致力于打造「以数据为中心」的专业化生成式AI数据服务,以及系列化生成式AI数据集产品,推进生成式AI技术的可持续性发展,加速生成式AI技术的行业落地。

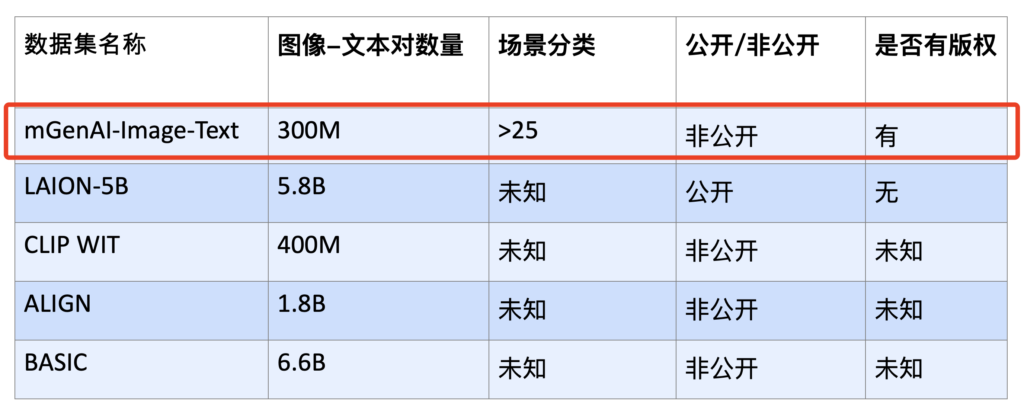

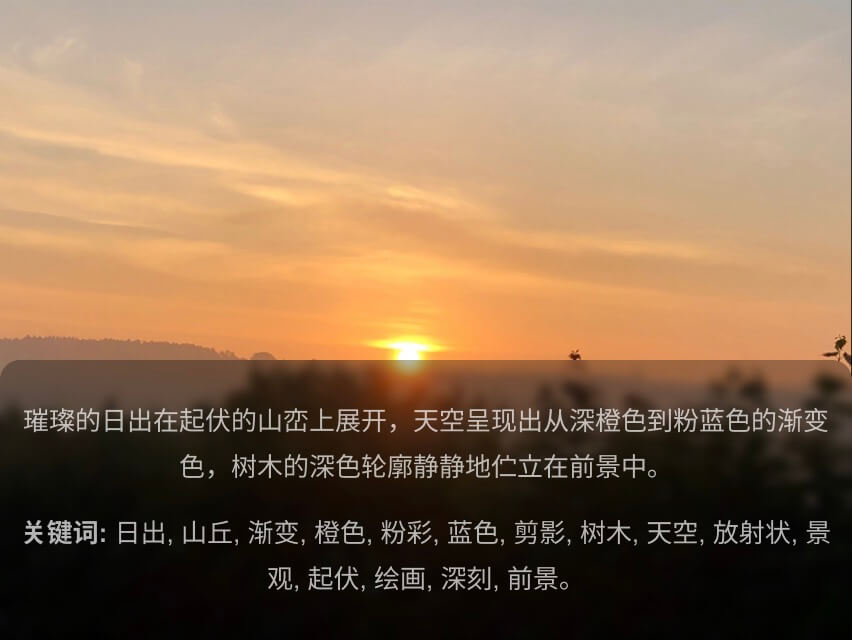

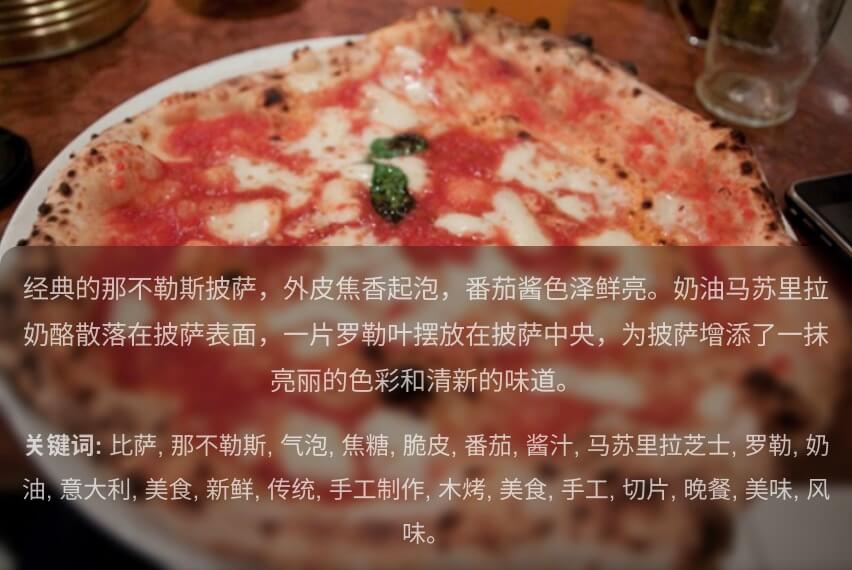

马达智数正式推出面向生成式AI多模态大模型(MLLMs)的数据集产品,其中图片-文本对数据集包含了超过3亿个图文配对,覆盖了广泛的高分辨率专业摄影图片,包括人物、动物、风景、摄影作品和矢量图像等类型。

以下是包括 LAION-5在内的几个MLLM训练数据集的对比表。

马达智数的多模态大模型数据集产品适用于多种应用场景,包括内容创作、高级研究、基于AI的数据分析、教育工具、互动娱乐以及自动化新闻报道等。这些应用展示了数据集的广泛用途和其在各行各业中的潜在影响力。

参考来源: